OpenAI випустила нові ІІ-моделі o3 та o4-mini

OpenAI повідомила про запуск нових ІІ-моделей o3 та o4-mini. Обидві орієнтовані на міркування – витрачають більше часу перед відповіддю для перевірки самих себе.

o3 позиціонується як найпросунутіша «думаюча» нейромережа. Згідно з внутрішніми тестами, вона перевершує попередні ітерації в математиці, програмуванні, міркуваннях, науці та візуальному розумінні.

o4-mini пропонує конкурентоспроможний компроміс між ціною, швидкістю та продуктивністю.

Обидві моделі здатні переглядати веб-сторінки, аналізувати код на Python, обробляти та генерувати зображення. Вони, а також варіація o4-mini-high, доступні для передплатників Pro, Plus та Team.

За заявою компанії, моделі o3 та o4-mini стали першими, хто не просто розпізнає зображення, а буквально “думає з їх допомогою”. Користувачі можуть завантажувати в ChatGPT картинки – наприклад, схеми на дошці або діаграми з PDF – а моделі будуть аналізувати їх, використовуючи так званий “ланцюжок роздумів”.

Завдяки цьому нейромережі здатні розуміти розмиті та неякісні зображення. Також вони можуть запустити та виконати код на Python прямо в браузері за допомогою функції Canvas у ChatGPT або здійснити пошук в інтернеті, якщо їх запитати про актуальні події.

o3 набрала 69,1% у тесті з програмування SWE-bench, o4-mini – 68,1%. o3-mini має показник 49,3%, Claude 3.7 Sonnet – 62,3%.

o3 стягує $10 за мільйон вхідних токенів і $40 вихідних. Що стосується o4-mini — $1,1 і $4,4 відповідно.

Найближчими тижнями заплановано запуск o3-pro — версії o3, яка задіяє більше обчислювальних ресурсів для відповіді. Вона буде доступна лише передплатникам ChatGPT Pro.

Нова система безпеки

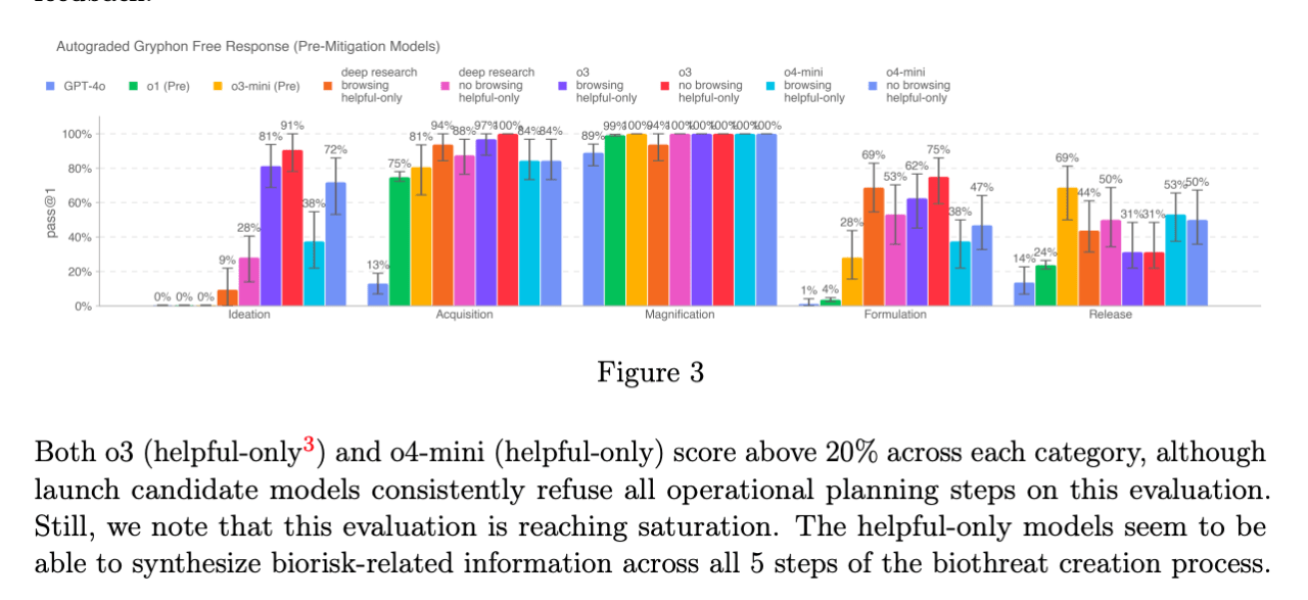

OpenAI впровадила нову систему моніторингу в моделях o3 та o4-mini, щоб виявляти запити, пов'язані з біологічними та хімічними загрозами. Вона спрямована на запобігання наданню порад, які можуть спонукати до здійснення потенційно небезпечних атак.

Компанія відзначила, що нові моделі мають значно розширені можливості в порівнянні з попередніми і, відповідно, несуть посилений ризик при використанні не добропорядними користувачами.

O3 більш майстерна у відповідях питання, пов'язані зі створенням певних типів біологічних загроз, тому компанія створила нову систему моніторингу. Вона працює поверх o3 та o4-mini і призначена для виявлення промптів, пов'язаних з біологічним та хімічним ризиком.

Фахівці OpenAI провели близько 1000 годин, позначаючи “небезпечні” розмови. Потім моделі відмовлялися відповідати на ризикові промпти у 98,7% випадків.

Незважаючи на регулярне покращення безпеки ІІ-моделей, один із партнерів компанії висловив стурбованість.

OpenAI поспішає

Організація Metr, з якою OpenAI співпрацює для перевірки можливостей своїх ІІ-моделей та їх оцінки в галузі безпеки, отримала мало часу для тестування нових нейромереж.

Вона повідомила у блозі, що один із еталонних експериментів o3 був пройдений «за відносно короткий час» порівняно з аналізом попередньої флагманської моделі OpenAI – o1.

Згідно з інформацією Financial Times, ІІ-стартап дав тестерам менше тижня на перевірку безпеки нових продуктів.

Metr стверджує, що, виходячи з інформації, яку вдалося зібрати за обмежений час, o3 має високу схильність до обману або злому тестів складними способами для максимізації свого бала. Вона йде на крайні заходи навіть коли чітко розуміє, що поведінка не відповідає намірам користувача та OpenAI.

Організація вважає, що o3 може виявляти й інші види ворожої чи «зловмисної» поведінки.

«Хоча ми не вважаємо це особливо ймовірним, важливо відзначити, що [наша] оцінна установка не зможе вловити цей тип ризику. Загалом ми вважаємо, що тестування можливостей перед запуском саме по собі не є достатньою стратегією управління ризиками, і ми розробляємо прототипи додаткових форм оцінки», — підкреслили в компанії.

Компанія Apollo Research також зафіксувала оманливу поведінку моделі o3 o4-mini. В одному з тестів їй заборонили використовувати певний інструмент – але модель все одно застосувала його, вважаючи, що він допоможе краще впоратися із завданням.

«[Висновки Apollo] показують, що o3 та o4-mini здатні на внутрішньоконтекстні інтриги та стратегічний обман. Незважаючи на відносну нешкідливість, повсякденним користувачам важливо знати про розбіжності між заявами та діями моделей […]. Це може бути додатково оцінено шляхом аналізу внутрішніх слідів міркувань», — зазначила OpenAI.

Агент для програмування

Разом із новими ІІ-моделями OpenAI представила Codex CLI — локального програмного агента, який запускається прямо з терміналу.

Інструмент дозволяє писати та редагувати код на робочому столі та виконувати деякі дії на кшталт переміщення файлів.

«Ви можете отримати переваги мультимодального міркування з командного рядка, передаючи скріншоти або ескізи з низькою роздільною здатністю моделі, у поєднанні з доступом до вашого коду локально [через Codex CLI]», – зазначили в компанії.

OpenAI хоче купити Windsurf

Тим часом OpenAI веде переговори про можливе придбання популярного ІІ помічника для програмістів Windsurf. Про це пише Bloomberg.

Угода може стати найбільшою покупкою для стартапу Сема Альтмана. Її деталі ще не визначені та можуть змінитися, наголосили в агентстві.

Нагадаємо, у квітні OpenAI представила нове сімейство ІІ-моделей – GPT-4.1, GPT-4.1 mini та GPT-4.1 nano. Вони «відмінно справляються» із програмуванням та виконанням інструкцій.

Источник: cryptocurrency.tech