OpenAI выпустили мультимодальную модель GPT-4o

Лаборатория OpenAI представила новую мультимодальную модель искусственного интеллекта GPT-4o. По данным компании, эта технология ― еще один шаг к «гораздо более естественному взаимодействию человека с компьютером».

Буква «o» в названии означает omni ― GPT-4o способна принимать на вход любую комбинацию текста, аудио и изображений и выдавать данные во всех трех форматах. Модель также умеет распознавать эмоции, позволяет прерывать себя в процессе речи и может реагировать так же быстро, как и человек во время беседы.

По словам технического директора стартапа Миры Мурати, новый алгоритм обеспечивает интеллект «уровня GPT-4», но обладает лучшими возможностями в различных модальностях и средах.

«[…] Последние пару лет мы были сосредоточены на повышении интеллекта моделей. Это первый раз, когда мы делаем огромный шаг вперед, когда дело касается простоты использования», ― отметила она.

Во время презентации OpenAI продемонстрировала работу GPT-4o. Алгоритм в прямом эфире перевел между английским и итальянским языками, помог исследователю решить линейное уравнение в реальном времени на бумаге и дал рекомендации по глубокому дыханию руководителю лаборатории.

Предыдущий «ведущий и самый продвинутый» алгоритм GPT-4 Turbo мог анализировать изображения и текст для выполнения задач вроде извлечения написанного из картинок или описания содержимого на них. Но GPT-4o добавляет обработку речи.

Из-за того, что новая модель обучена использованию трех форматов данных, входная и выходная информация обрабатывается одной и той же нейронной сетью. Предшественники ― GPT-3.5 и GPT-4 ― позволяли пользователям задавать вопросы голосом, а затем транскрибировали звук в текст. Это лишало речь интонаций и эмоций и делало взаимодействие более медленным.

Благодаря GPT-4o использование ChatGPT стало похоже на общение с помощником.

Например, при разговоре с чат-ботом, базирующимся на новой модели, его можно прервать во время ответа. Согласно OpenAI, алгоритм обеспечивает реакцию «в реальном времени» и может даже улавливать нюансы звучания пользователя, генерируя в ответ голоса «в различных эмоциональных стилях», включая пение.

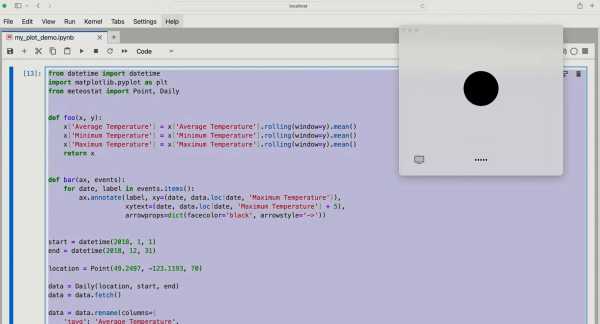

GPT-4o расширяет возможности ChatGPT в плане зрения. Получив фотографию или экран рабочего стола, чат-бот теперь способен быстро отвечать на связанные с ними вопросы, начиная от «что происходит в этом программном коде?» и заканчивая «какая марка рубашки на этом человеке?».

По словам Мурати, в будущем эти функции будут развиваться. Хотя GPT-4o способна просматривать изображение меню на иностранном языке и переводить его, позже модель позволит ChatGPT, например, «смотреть» спортивную игру в прямом эфире и объяснять ее правила.

В лаборатории заявили, что новый алгоритм более многоязычен ― он может понимать около 50 языков.

Согласно компании, через API OpenAI и Azure OpenAI Service от Microsoft новая модель работает в два раза быстрее, распространяется дешевле и менее ограничена по скорости в сравнении с GPT-4 Turbo.

Пока поддержка голоса в API GPT-4o не распространяется на всех клиентов. Ссылаясь на риск неправомерного использования в компании отметили, что сперва запустят эту функцию для «небольшой группы доверенных партнеров» в ближайшие недели.

OpenAI предоставит новую модель для всех, включая бесплатных пользователей ChatGPT, в течение следующих недель. Владельцы премиум-подписок Plus и Team получат к ней доступ с «в пять раз меньшим» ограничением по количеству обращений.

Лаборатория объявила о запуске обновленного пользовательского веб-интерфейса ChatGPT с «более диалоговым» главным экраном и макетом сообщений.

Также OpenAI представила настольную версию чат-бота для macOS, доступ к которой платные пользователи получат начиная с сегодняшнего дня. Версия для Windows появится позже в этом году.

Кроме того, бесплатные пользователи ChatGPT получат доступ к GPT Store ― библиотеке и инструментам для создания сторонних чат-ботов с ИИ. Также им откроют некоторые ранее платные опции ChatGPT вроде функции «памяти».

Ранее СМИ утверждали, что 13 мая OpenAI представит поисковую систему на базе искусственного интеллекта.

Источник: cryptocurrency.tech